Es el caso de varias víctimas de ciberdelincuentes que, haciéndose pasar por el actor estadounidense, lograron engañar y robar varios miles de dólares. Se supo en marzo de este año, pero en apenas unos meses la IA ha avanzado tanto que ahora las imágenes fotorrealistas son capaces de poner en duda lo que es cierto.

Newsletter exclusivo para suscriptores

VER TAMBIÉN: Un presentador generado por IA realiza un documental sobre el impacto de esta tecnología

Hace una semana que Microsoft lanzó su modelo de IA llamado MAI-Image-1 para obtener resultados fotorrealistas que se alejan de lo genérico y repetitivo. Pero hace dos meses Google hizo lo propio con Nano Banana (Gemini 2.5 Flash Image), su herramienta de generación de imágenes. Y así, cada empresa de inteligencia artificial se ha ido superando a sí misma.

María Isabel Manjarrez, investigadora de seguridad de Kaspersky, indicó que los ciberdelincuentes han logrado hacerse pasar por personajes famosos, artistas o personas involucradas en la política, con una perfección que ya es un riesgo.

“Esto erosiona la confianza de los usuarios porque así como podemos creer que algo falso es verdad, también podemos dejar de creer que todo es verdad. Entonces, la confianza también se ve afectada a medida que se explota más este uso de la inteligencia artificial”.indicó en conversación con el comercio.

Amador Rivera Herrera, especialista en Inteligencia Artificial Generativa y Marketing Digital, tiene una opinión similar, aunque indica que hay que distinguir entre el uso ético de la IA y el uso criminal, ya que «El problema no es la tecnología»..

En ese sentido, alertó sobre la falta de regulación en el Perú para el correcto uso de la IA, estableciendo protocolos, sanciones específicas, entre otras medidas. “Los riesgos son principalmente que la gente empiece a creer en estas imágenes, que los jueces no estén preparados para un juicio de esa naturaleza”. y que, al menos desde el lado periodístico, la gente empiece a difundir noticias con esta información falsa”comentó a este periódico. En esa situación el riesgo sería mayor porque viviríamos en un “lugar de desinformación total y eso sí se convierte en caos”.

Además…

La IA como factor agravante

En abril de este año, el gobierno de Dina Boluarte publicó el Ley N° 32314que modifica el Código Penal y la Ley de Delitos Informáticos para integrar en la normativa el uso de la inteligencia artificial como agravante. El caso deepfake es mencionado en delitos como pornografía infantil, difamación, estafa agravada, entre otros.

Por otro lado, aunque las herramientas de IA mencionadas anteriormente son de empresas reconocidas y más monitoreadas, Rivera Herrera también recuerda que se pueden crear modelos de IA gratuitos, a los que se les suministran imágenes para generar nuevas fotos falsas.

¿Cómo actúan los ciberdelincuentes?

Aunque la inteligencia artificial brinda muchas oportunidades para trabajar, estudiar, investigar, crear, los ciberdelincuentes también pueden utilizarla de diferentes maneras.

Kaspersky ha evaluado la forma de operar. El tipo de violación se conoce como Deepfake, que consiste en la manipulación de vídeo, audio o imagen con la intención de hacerlo pasar como real.

VER TAMBIÉN:Internet, el campo de batalla de los titanes de la inteligencia artificial que crean sus navegadores

La modalidad principal está relacionada con la estafa, donde el objetivo es financiero, es decir, robar dinero. “Hay muchas estafas haciéndose pasar por esos personajes famosos donde los invitan a invertir, donde los invitan a depositar dinero, quizás por alguna buena causa, pero esto es una estafa”indicó Manjarrez.

Una variante actual de este tipo de estafas está relacionada con la inversión en criptomonedas.

Otra situación es la suplantación de identidad, con el fin de extorsionar o dañar una buena imagen. Manjarrez precisa que “La imagen puede ser manipulada digitalmente, con inteligencia artificial, para ponerlos en una situación comprometedora y victimizarlos, para luego estafarlos o chantajearlos”.

El problema es que las modalidades de deepfake son tan recientes que todavía no hay estadísticas claras. Lo que sí se sabe es que, según un informe de Kaspersky, la mayoría de usuarios en Perú (57%) no reconoce cuando un video ha sido editado digitalmente mediante la técnica del deepfake.

Una videollamada puede ser la puerta a caer en manos de cocriminales que roban tu imagen para generar deepfakes. (Foto de referencia: pexels.com)

Pero los ciberdelincuentes también encuentran formas de robar información, y una de ellas es a través de videollamadas.

“Lo primero que hacen los extorsionadores es hacerte una videollamada desde un número, respondes inocentemente, pero cuando respondes ya capturaron tu cara”. y luego empiezan a hacer un deepfake con esa imagen. Ese es uno de los principales riesgos hoy”indicó Rivera Herrera.

Y si estas imágenes son tan realistas como se estima, ¿qué posibilidades hay de separar lo verdadero de lo falso?

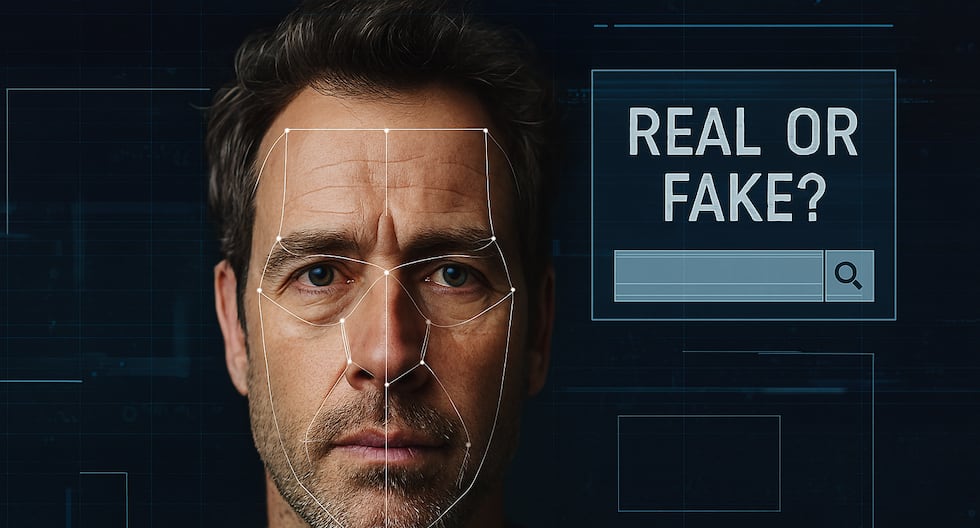

Identificar una imagen real o falsa

Hasta hace unos meses, diferenciar una imagen real de una falsa podía resultar relativamente sencillo. Bastaba con contar los dedos de una persona en la imagen, detectar una imperfección en los ojos, los dientes, etc. Hoy eso ha cambiado.

Reconocer que una imagen es verdadera o falsa depende del ser humano y de su capacidad de investigación. (Foto de referencia: pixabay.com)

Para Rivera Herrera, las imágenes generadas con IA son casi 100% confiables, casi perfectas, que incluso las herramientas que prometen verificar el contenido generado suelen fallar. Una de las opciones es Google Lens, para evaluar el contenido, pero la más precisa es el ojo humano y ampliar la fotografía o vídeo en una computadora.

“De momento se trata de utilizar una lupa y ver cada punto de una imagen, verifica que efectivamente sea real, y cuando notes alguna distorsión, es síntoma de que pudo generarse con IA”le dijo a este periódico.

VER TAMBIÉN: Elon Musk pide el pago de mil millones de dólares para mantener el control del ejército de robots que construye Tesla

Cuando se trata de una foto o video, también puedes evaluar algunas distorsiones en la voz, anomalías en el fondo o ambiente, movimientos inusuales o irregulares, iluminación, cambios en el tono de la piel en un mismo video, incluso si hay o no parpadeos, labios que no sincronizan con el audio o la imagen es de baja calidad.

Pero hay algo sobre lo que también advierte María Isabel Manjarrez: el contexto. Para el investigador de Kaspersky, el factor humano sigue siendo importante para diferenciar si un contenido es verdadero o falso.

«Además de lo visual, también necesitamos verificar la información, incluso si parece súper realista, tengo que buscarla en Google».o tengo que ir a ponerlo en un navegador para buscar la información si esto es real o no. «Siempre se recomienda leer los comentarios, investigar más, acudir a una segunda fuente, no quedarse con la primera noticia».explicó.

Aunque la inteligencia artificial no es una amenaza (al fin y al cabo, es una herramienta como muchas), el riesgo de caer en un Deepfake sigue creciendo. Corresponderá a cada persona probar cada imagen encontrada en las redes sociales, en Internet, en cualquier momento del día.