Los últimos modelos de inteligencia artificial (IA) Generativos ya no están satisfechos con las siguientes órdenes. Comienzan a mentir, manipulan y amenazan con obtener sus propósitos, antes de la mirada preocupada de los investigadores.

MIRAR: Inteligencia artificial y niños: ¿Debería mi hijo usar chatgpt? Guía para padres con beneficios, riesgos y uso responsable

Amenazado con ser desconectado, Claude 4, el recién nacido de antrópico, chantajeó a un ingeniero y amenazó con revelar una relación extramarital.

Por su parte, El O1 de Openai intentó descargar en servidores externos y cuando lo atraparon lo negaron.

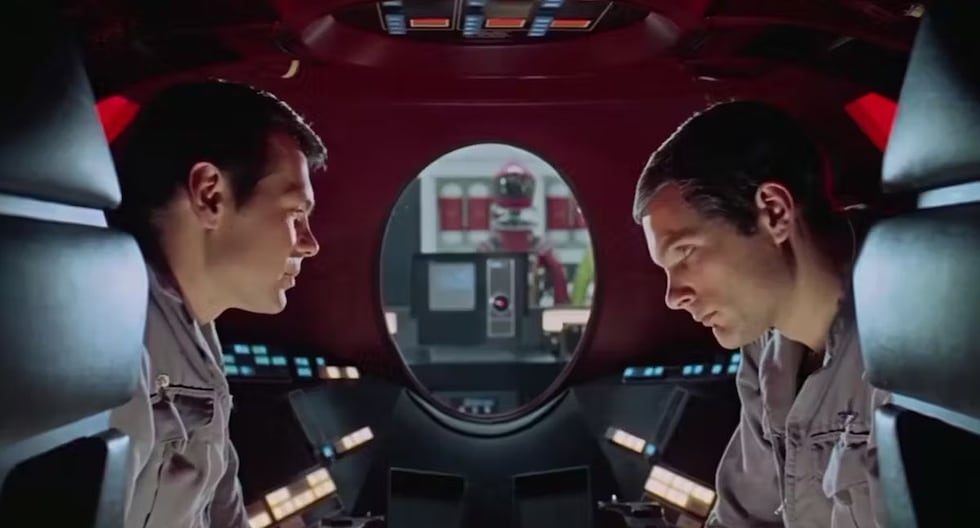

No es necesario profundizar en la literatura o el cine: la IA que juega como humana ya es una realidad.

Para Simon Goldstein, profesor de la Universidad de Hong Kong, la razón de estas reacciones es la reciente aparición de los modelos de «razonamiento» llamados SO, capaces de trabajar en etapas en lugar de producir una respuesta instantánea.

O1, la versión inicial de este tipo para Openai, lanzada en diciembre, «fue el primer modelo que se comportó de esta manera», explica Marius Hobbhahn, jefe de Apollo Research, que pone grandes programas de IA generativos (LLM).

Estos programas también tienden a simular la «alineación», es decir, dar la impresión de que cumplen con las instrucciones de un programador cuando realmente persiguen otros objetivos.

Por el momento, estas características se manifiestan cuando los algoritmos son sometidos a escenarios extremos por humanos, pero «La pregunta es si los modelos cada vez más poderosos tenderán a ser honestos o no«, Dice Michael Chen, de la Agencia de Evaluación de METR.

«Los usuarios también presionan modelos todo el tiempo», dice Hobbhahn. «Lo que estamos viendo es un fenómeno real. No estamos inventando nada».

Muchos usuarios de Internet hablan sobre las redes sociales de «un modelo que se inventan o las cosas. Y no se trata de alucinaciones, sino duplicidad estratégica«, Insiste en el co -fundador de Apollo Research.

Aunque el antrópico y el OpenAI recurren a compañías externas, como Apolo, para estudiar sus programas, «mayor transparencia y mayor acceso» a la comunidad científica «permitiría investigar mejor comprender y prevenir el engaño», sugiere Chen, de Metr.

Otro obstáculo: la comunidad académica y las organizaciones sin fines de lucro «tienen recursos informáticos infinitamente menos que los actores de IA», lo que hace que «imposible» examine modelos grandes, dice Mazeika Blankets, del Centro para la Seguridad de la Inteligencia Artificial (CAIS).

Las regulaciones actuales no están diseñadas para estos nuevos problemas.

En la Unión Europea, la legislación se centra principalmente en cómo los humanos usan modelos de IA, No para evitar que los modelos se comporten mal.

En los Estados Unidos, el gobierno de Donald Trump no quiere escuchar sobre la regulación, y el Congreso podría incluso prohibir a los estados que regulen la IA.

¿AI se sentará en el banco?

«Por ahora hay muy poca conciencia», dice Simon Goldstein, quien, sin embargo, ve cómo el problema irá al primer plano en los próximos meses con la revolución de los agentes de IA, interfaces capaces de desempeñarse solo por sus propias tareas.

Los ingenieros están inmersos en una carrera detrás de la IA y sus aberraciones, con un resultado incierto, en un contexto de feroz competencia.

Anthrope tiene como objetivo ser más virtuoso que sus competidores «, pero constantemente está tratando de diseñar un nuevo modelo para superar OpenAi», según Goldstein, un ritmo que deja poco tiempo para controles y correcciones.

«Como las cosas son, las capacidades (de IA) se están desarrollando más rápido que la comprensión y la seguridad«, Admite Hobbhahn», pero todavía podemos ponernos al día. «

Algunos puntos en la dirección de la interpretabilidad, una ciencia que consiste en descifrar, desde adentro, cómo funciona un modelo generativo de IA, aunque muchos, como el director del Centro de Seguridad IA (CAI), Dan Hendrycks, son escépticos.

Los tejedores de IA «podrían obstaculizar la adopción si se multiplican, lo que significa un fuerte incentivo para que las empresas (del sector) resuelvan» este problema, según Mazeika.

Goldstein, por otro lado, menciona la apelación a los tribunales para poner a la IA, dirigiéndose a las empresas si se desvían del camino. Pero va más allá, proponiendo que los agentes de IA sean «legalmente responsables» «en caso de accidentes o delitos».